国内首个全国产化千亿参数细粒度 MoE:开源!

TeleChat3-105B-A4.7-Thinking,国内首个全国产化训练的千亿参数细粒度MoE语义大模型,开源!

代码:https://github.com/Tele-AI/TeleChat3

模型:https://www.modelscope.cn/models/TeleAI/TeleChat3-105B-A4.7B-Thinking

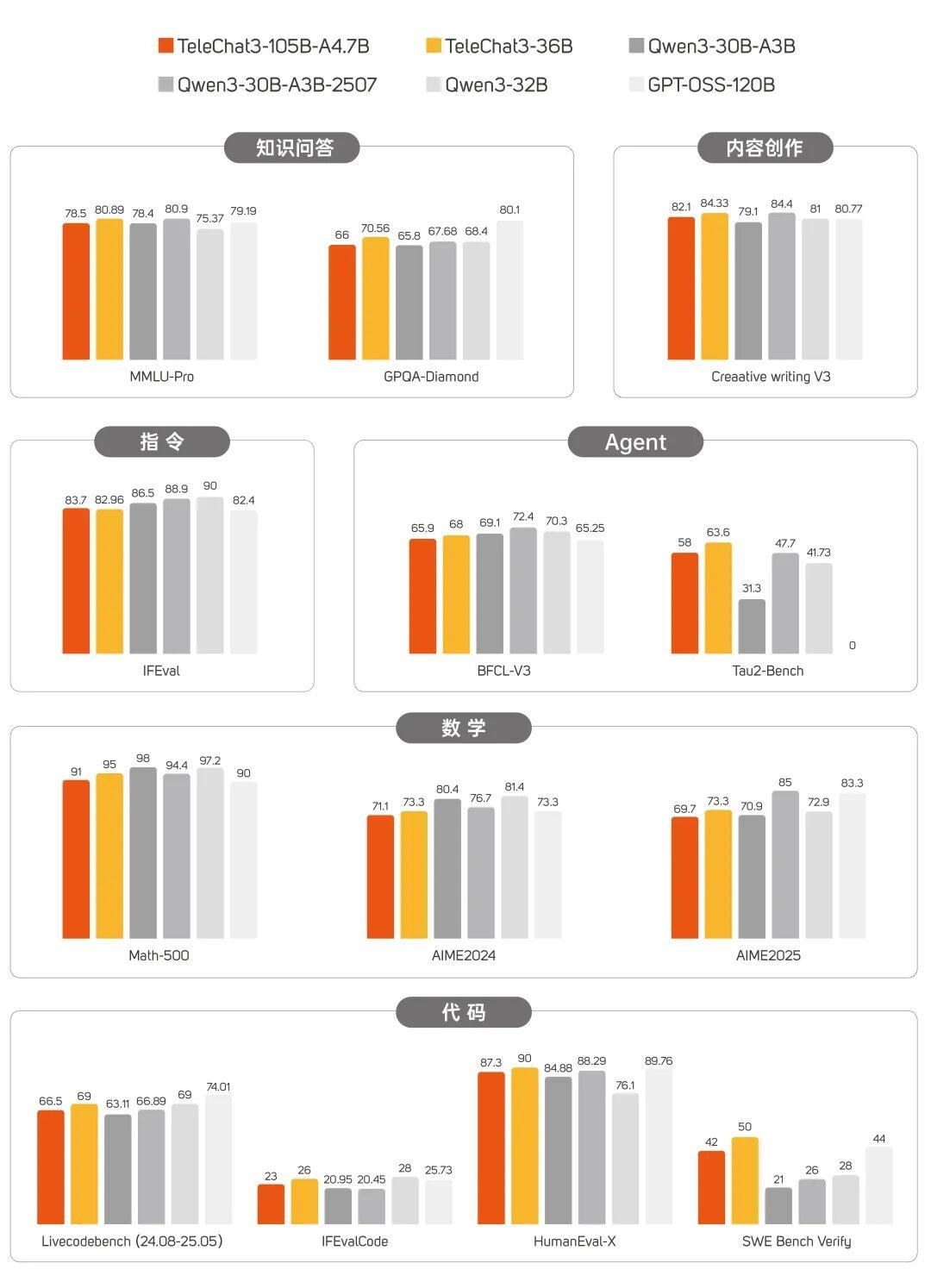

问答、写作、数学、代码、Agent......多维度比肩业内头部!

代码能力提升,复杂任务拿捏住了!

面对综合任务场景,TeleChat3-105B-A4.7-Thinking高效拆解任务需求,整合多项代码能力,一次性交付出完整可运行的代码。

省去大量人工调试时间投入,运行流畅,审美在线!

📎0b2e3yakiaaanyah4ss4lfuvbxwdutpabjaa.f10002.mp4

由 TeleChat3-105B-A4.7-Thinking 独立完成的射击类小游戏

📎0b2ezual6aaafaaglgk4xfuvbtodx7gqbpya.f10002.mp4

由TeleChat3-105B-A4.7-Thinking 设计的视频网站页面

细粒度MoE,术业有专攻,协同更高效!

此前,中国电信人工智能研究院(TeleAI)与中电信人工智能科技有限公司已陆续开源原创打造的 TeleChat、TeleChat2 及TeleChat2.5系列模型,以传统稠密参数架构为主,模型尺寸覆盖十亿到千亿,构建了全尺寸大模型开源布局。

上半年,星辰语义大模型的首个MoE架构模型TeleChat2-39B-A12B也正式开源,采用粗粒度MoE架构,初步实现知识模块化存储,按需唤醒相关专家模块。

为了进一步提升MoE 大模型的效率与性能,让参数利用更充分,在中国电信集团 CTO、首席科学家、中国电信人工智能研究院(TeleAI)院长李学龙教授的带领下,TeleAI科研团队以智传网(AI Flow)为理论基础,完成了TeleChat3-105B-A4.7-Thinking的全国产化训练。

该模型采用细粒度MoE架构,基础模型训练数据超15T,共包括1个共享专家和192个路由专家(每次激活4个专家),模型整体共105B参数量,实际激活参数为 4.7B,专家稀疏比处于业界前列。

面对不同的任务类型,更加细分的专家子模块实现了术业有专攻,模块之间也实现了更精准、更任务导向的协同。

打个比方,假如大模型是个理综考生,稠密参数大模型就是从一本“十年高考真题大全”合订本里找思路,知识庞杂,效率低下。粗粒度模型,则实现了初步的学科分类和调用,减少了无效的知识调用。细粒度MoE,则是更进一步,特定的题目只调用特定的细分知识点组合,见招拆招,精准调配。

此外,TeleAI还同步开源了稠密参数模型TeleChat3-36B-Thinking模型,在知识、逻辑推理、智能体等维度实现了能力提升,并实现了文本创作、语义理解、角色扮演等任务的针对性优化。

训练黑科技拉满,收敛稳、效率优

训练方式创新

TeleAI 科研团队采用细粒度的模型初始化方式和学习率控制,对不同权重采用不同的初始化方式和学习率,加快模型在训练初期的收敛速度,增强模型在训练中的稳定性。

基础模型训练通过两个阶段预训练和一个阶段中训练完成,总计训练 15T tokens。

预训练第一阶段以通识数据(网页、书籍、多语言数据等)为主,主要提升模型知识能力;第二阶段增大 STEM 和代码相关数据占比,提升模型推理相关能力。

中训练阶段以合成数据为主,包含仓库级代码任务、高质量数理逻辑数据以及智能体任务数据,持续提升模型逻辑推理和智能体相关能力。

后训练也包含两个阶段:

第一阶段模型冷启动微调,为取得更好的冷启动效果,针对微调数据难度和多样性做了大量筛选工作,大幅提升模型多任务理解及指令遵从能力。

第二阶段强化学习,采用基于规则校验奖励和 RM 打分模型融合的方式。针对数理、代码、指令遵循等采用规则校验;针对文本创作、语义理解、角色扮演等任务采用专项训练 RM 模型进行打分。

国产算力优化

基于中国电信上海临港国产万卡算力池,科研团队在MoE 模块中将 Tensor 并行域转换成专家并行域,从而将 MoE 的 “All to All” 通讯约束在节点内,提高通讯效率。

为了解决长序列训练时预训练文本拼接长度不一致带来的性能劣化,团队引入了micro 级别的动态拼接,缓解计算负载的不均衡,减少了计算波动。

对于复杂的并行策略调优,则采用了自动并行工具来加速搜索、优化并行方式,节约搜索和调优成本。

目前,TeleChat3-105B-A4.7-Thinking已经登陆 GitHub、ModelScope,欢迎开发者们前往体验!

https://github.com/Tele-AI/TeleChat3

开源地址:

https://github.com/Tele-AI/TeleChat3

模型链接:

https://www.modelscope.cn/models/TeleAI/TeleChat3-105B-A4.7B-Thinking

点击即可跳转模型链接~

https://modelscope.cn/models/TeleAI/TeleChat3-105B-A4.7B-Thinking

更多推荐

已为社区贡献909条内容

已为社区贡献909条内容

所有评论(0)