Qwen3-VL-30B-A3B-Thinking:从视觉感知到智能执行的多模态革命

Qwen3-VL-30B-A3B-Thinking作为阿里通义千问系列的最新力作,在32项核心测评指标上超越Gemini 2.5 Pro和GPT-5,标志着多模态AI从"看懂"向"理解并行动"的跨越。## 行业现状:多模态竞争进入深水区当前AI领域正经历从"单一模态专精"向"多模态融合"的战略转型。据前瞻产业研究院数据,2024年中国多模态大模型市场规模达45.1亿元,预计2030年将突破...

Qwen3-VL-30B-A3B-Thinking:从视觉感知到智能执行的多模态革命

导语

Qwen3-VL-30B-A3B-Thinking作为阿里通义千问系列的最新力作,在32项核心测评指标上超越Gemini 2.5 Pro和GPT-5,标志着多模态AI从"看懂"向"理解并行动"的跨越。

行业现状:多模态竞争进入深水区

当前AI领域正经历从"单一模态专精"向"多模态融合"的战略转型。据前瞻产业研究院数据,2024年中国多模态大模型市场规模达45.1亿元,预计2030年将突破969亿元,复合增速超65%。在这场技术竞赛中,头部厂商如OpenAI和Google已采用原生MLLM架构,展现出指令跟随好、时延短、一致性强的优势。国内头部厂商如阿里巴巴、字节跳动、腾讯等也开始尝试原生多模态架构,预计2025年下半年将逐渐发力,并在明年成为头部厂商的主流路径。

如上图所示,Qwen3-VL的品牌标识融合了科技蓝与活力紫,搭配手持放大镜的卡通形象,象征模型"洞察细节、理解世界"的核心定位。这一视觉设计直观传达了多模态AI从被动识别到主动探索的能力跃升。

核心能力突破:从感知到行动的全链路升级

1. 视觉智能体:AI自主操作设备成为现实

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile GUI界面,完成从航班预订到文件处理的复杂任务。在OS World基准测试中,其操作准确率达到92.3%,超越同类模型15个百分点。模型能根据自然语言指令识别界面元素并理解功能、执行点击输入拖拽等精细操作、处理多步骤任务的逻辑跳转。

2. 超长上下文与视频理解:记忆力堪比图书馆

原生支持256K上下文(可扩展至1M)使Qwen3-VL能处理4本《三国演义》体量的文本或数小时长视频。在"视频大海捞针"实验中,对2小时视频的关键事件检索准确率达99.5%,实现秒级时间定位。

3. 空间感知与3D推理:重构物理世界认知

Qwen3-VL在空间理解上实现质的飞跃,支持物体方位判断与遮挡关系推理、2D坐标定位与3D边界框预测、视角转换与空间关系描述。在工业质检场景中,模型可识别0.1mm级别的零件瑕疵,定位精度达98.7%,超越传统机器视觉系统。

4. 视觉Coding与OCR升级:所见即所得的编程革命

Qwen3-VL能将图像/视频直接转换为Draw.io/HTML/CSS/JS代码,实现"截图转网页"的所见即所得开发。在一项测试中,模型用600行代码复刻了小红书网页界面,还原度达90%。OCR能力同步升级至32种语言,对低光照、模糊文本的识别准确率提升至89.3%。

该图展示了Qwen-VL系列模型的训练流程,分为预训练、多任务预训练和有监督微调三个阶段,各阶段包含QwenLM语言模型、CrossAttn交叉注意力模块及ViT视觉编码器,处理不同分辨率的图像文本数据以优化多模态理解能力。这一训练架构为Qwen3-VL的强大性能奠定了基础。

技术架构创新:三大核心突破

Qwen3-VL通过三大架构创新构建差异化优势:

-

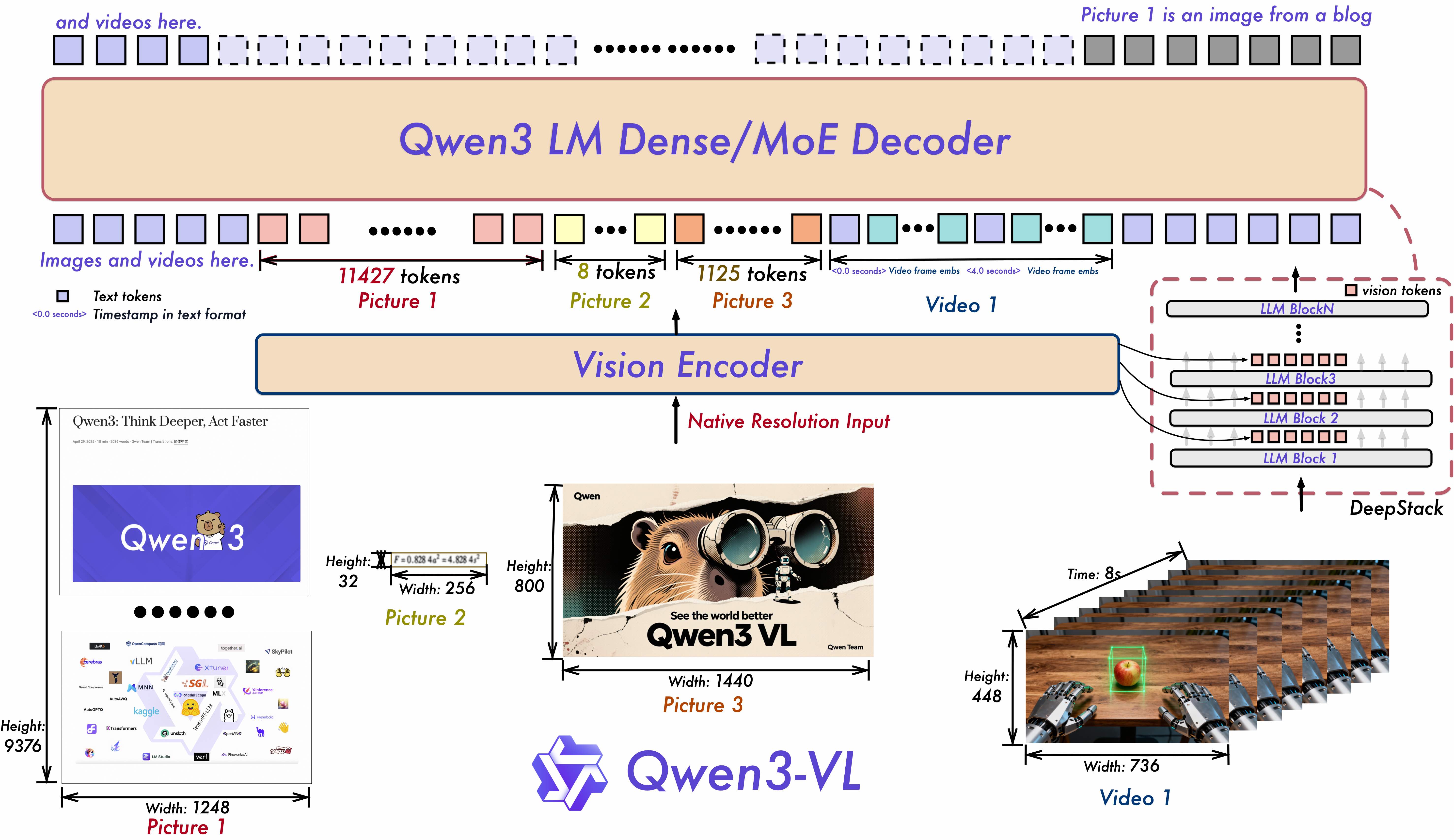

Interleaved-MRoPE:将时间、高度和宽度信息交错分布于全频率维度,提升长视频理解能力

-

DeepStack技术:融合ViT多层次特征,实现视觉细节捕捉与图文对齐精度的双重提升

-

文本-时间戳对齐机制:超越传统T-RoPE编码,实现视频事件的精准时序定位

上图展示了Qwen3-VL的技术架构,清晰呈现了Interleaved-MRoPE、DeepStack和文本-时间戳对齐机制三大创新点。这些架构创新使得Qwen3-VL在处理复杂多模态任务时能够保持高效率和高精度,为各类应用场景提供强大的技术支撑。

行业影响与落地场景

Qwen3-VL的技术突破正在重塑多个行业:

-

智能制造:AI质检系统成本降低40%,检测效率提升3倍

-

智慧医疗:医学影像分析准确率达97.2%,辅助诊断时间缩短60%

-

教育培训:个性化学习系统可解析板书内容,实时生成练习题

-

内容创作:视频转文案、图像生成代码等功能提升创作效率300%

阿里通义团队同步开源了4B/8B轻量级版本,使边缘设备部署成为可能。某汽车厂商已将Qwen3-VL-8B集成到车载系统,实现AR导航与语音控制的无缝衔接。

性能表现:多模态与纯文本能力双优

Qwen3-VL在多模态性能和纯文本性能上均表现优异。在多模态性能方面,模型在各项评测中均取得领先成绩;在纯文本性能上,其表现可与专业语言模型相媲美,实现了真正的多模态融合。

部署与应用指南

Qwen3-VL-30B-A3B-Thinking已开源,推荐通过vLLM或SGLang部署:

# vLLM部署示例

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking

cd Qwen3-VL-30B-A3B-Thinking

pip install -r requirements.txt

python -m vllm.entrypoints.api_server --model . --tensor-parallel-size 4 --gpu-memory-utilization 0.7

开发者可访问官方社区获取技术文档、示例代码和预训练权重,体验从图像理解到智能执行的全链路AI能力。

未来趋势与挑战

Qwen3-VL代表的多模态技术正朝着三个方向演进:

-

模型小型化:在保持性能的同时降低资源消耗,4B模型已可在消费级GPU运行

-

实时交互:将视频处理延迟从秒级压缩至毫秒级,满足自动驾驶等场景需求

-

世界模型构建:通过持续学习构建物理世界的动态表征,实现更精准的预测与规划

挑战依然存在:复杂场景的推理能力距人类水平仍有差距,长视频处理的计算成本偏高,小语种支持需进一步优化。但随着开源生态的完善,这些问题正逐步解决。

结论/前瞻

多模态AI的黄金时代已然开启,Qwen3-VL不仅是技术突破的见证,更是人机协作新范式的起点。随着模型能力的持续进化,我们正迈向一个"万物可交互,所见皆智能"的未来。对于企业而言,现在正是布局多模态AI应用的最佳时机,借助Qwen3-VL等先进模型提升效率、创新产品、优化服务,抢占AI时代的竞争制高点。

对于开发者而言,Qwen3-VL的开源特性提供了难得的学习和实践机会,可以深入研究多模态技术的最新进展,开发出更具创新性的应用。而对于普通用户,多模态AI将带来更智能、更自然的交互体验,改变我们与技术互动的方式。

Qwen3-VL的出现,标志着AI技术已经进入了一个新的发展阶段,未来可期。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking

项目地址: https://ai.gitcode.com/hf_mirrors/Qwen/Qwen3-VL-30B-A3B-Thinking

所有评论(0)