号称全球最强开源模型 ——Qwen2.5 系列震撼来袭!

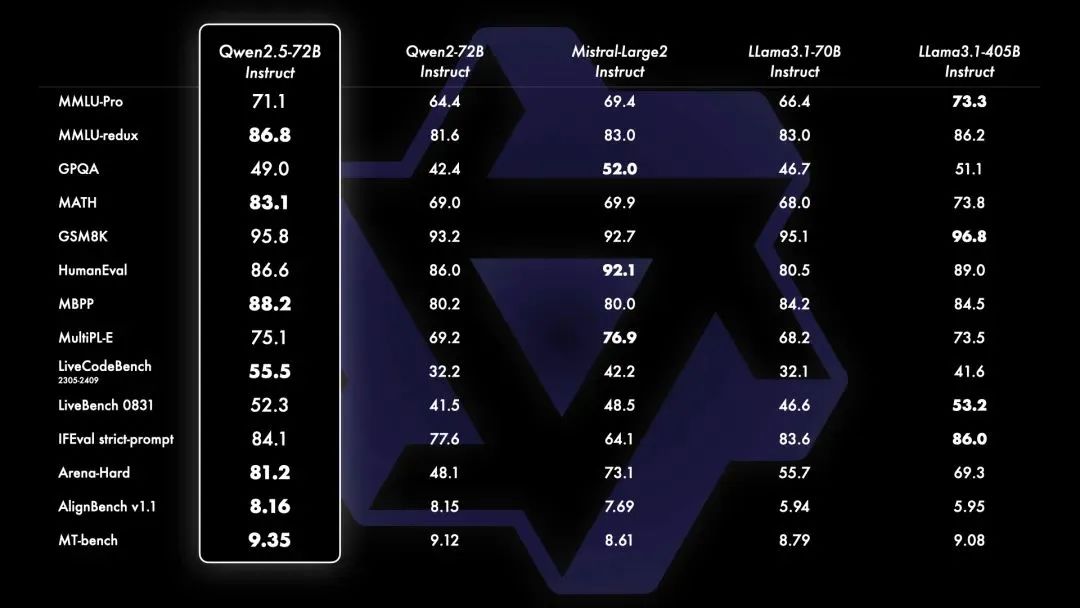

相较于Qwen2,Qwen2.5获得了显著更多的知识(MMLU:85+),并在编程能力(HumanEval 85+)和数学能力(MATH 80+)方面有了大幅提升。:即用于编程的Qwen2.5-Coder和用于数学的Qwen2.5-Math,相比其前身CodeQwen1.5和Qwen2-Math有了实质性的改进。,最新发布包括了语言模型Qwen2.5,以及专门针对编程的Qwen2.5-Coder和

9月19日凌晨,阿里通义千问正式开源Qwen2.5系列大模型,最新发布包括了语言模型Qwen2.5,以及专门针对编程的Qwen2.5-Coder和数学的Qwen2.5-Math模型。PerfXCloud (perfxlab.cn)(澎峰云)大模型开发与服务平台第一时间支持Qwen2.5 72B并在平台完成上线,赶快来体验吧!

Qwen2.5系列模型

-

更大的训练数据集:Qwen2.5语言模型的所有尺寸都在最新的大规模数据集上进行了预训练,该数据集包含多达18Ttokens。相较于Qwen2,Qwen2.5获得了显著更多的知识(MMLU:85+),并在编程能力(HumanEval 85+)和数学能力(MATH 80+)方面有了大幅提升。

-

更强的指令遵循能力:新模型在指令执行、生成长文本(超过8K标记)、理解结构化数据(例如表格)以及生成结构化输出特别是JSON方面取得了显著改进。Qwen2.5模型总体上对各种system prompt更具适应性,增强了角色扮演实现和聊天机器人的条件设置功能。

-

长文本支持能力:与Qwen2类似,Qwen2.5语言模型支持高达128K tokens,并能生成最多8K tokens的内容。

-

强大的多语言能力:它们同样保持了对包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文、韩文、越南文、泰文、阿拉伯文等29种以上语言的支持。

-

专业领域的专家语言模型能力增强:即用于编程的Qwen2.5-Coder和用于数学的Qwen2.5-Math,相比其前身CodeQwen1.5和Qwen2-Math有了实质性的改进。具体来说,Qwen2.5-Coder在包含5.5T tokens编程相关数据上进行了训练,使即使较小的编程专用模型也能在编程评估基准测试中表现出媲美大型语言模型的竞争力。同时,Qwen2.5-Math支持中文和英文,并整合了多种推理方法,包括CoT(Chain of Thought)、PoT(Program of Thought)和TIR(Tool-Integrated Reasoning)。

Qwen2.5-72B在多个基准测试中的结果

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)